【週次レポート自動化】AIエージェントによる「データパイプライン」構築:競合分析からメール配信まで

データ駆動型経営が求められる現代において、多くの企業が同じ課題に直面しています。毎週、営業データ、顧客情報、競合情報を手作業で収集し、加工し、レポートにまとめ、関係者にメール配信する。この一連の作業は、時間がかかり、エラーが発生しやすく、人的リソースを大量に消費します。本記事では、AIエージェント「Manus」が実現する「データパイプラインの完全自動化」を解説します。データ抽出から分析、レポート作成、定期配信まで、すべてをAIが自律的に実行する仕組みを紹介します。

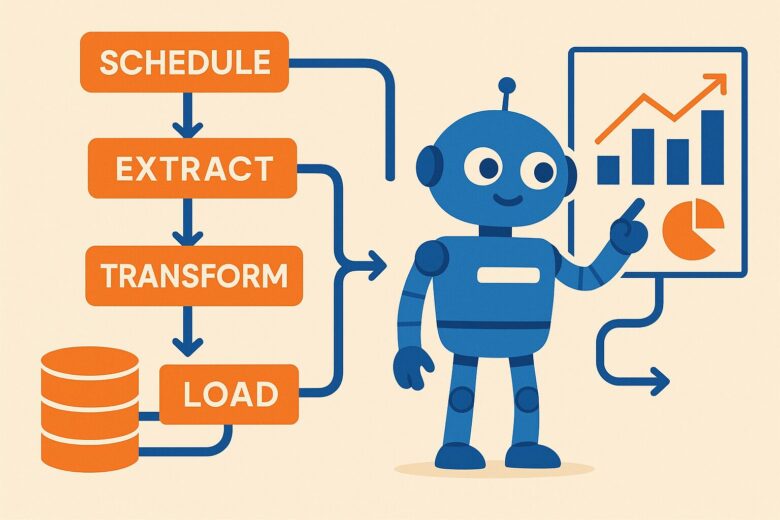

データパイプラインとは?なぜ自動化が必要なのか

データパイプラインとは、データの抽出(Extract)、変換(Transform)、ロード(Load)という一連の流れを指します。これを「E-T-L」と呼びます。

抽出(Extract)の段階では、複数のデータソース(Webサイト、API、データベース、スプレッドシートなど)からデータを集めます。変換(Transform)の段階では、集めたデータをクレンジング(不正なデータの除去)、正規化(形式の統一)、集計(合計、平均などの計算)します。ロード(Load)の段階では、変換済みのデータを目的地(データウェアハウス、ビジネスインテリジェンスツール、レポートなど)に格納します。

従来、このE-T-Lプロセスは、プログラマーやデータエンジニアが手作業で構築・維持していました。Pythonスクリプトを書き、エラーハンドリングを実装し、スケジューリングツール(cronなど)で定期実行を設定する必要がありました。このアプローチは、専門知識が必要であり、構築・維持にコストがかかります。

Manusのような次世代AIエージェントの登場により、その状況が大きく変わろうとしています。ユーザーが「何をしたいのか」を指示するだけで、AIが「どのようにするのか」を自動的に実行するのです。

ManusによるデータパイプラインのE-T-L:全工程の自動化

Manusが、データパイプラインの各段階をどのように自動化するのかを、具体的に説明します。

ステップ1: データ抽出(Extract)の自動化

Manusは、複数のデータソースからデータを自動的に抽出します。例えば、競合企業のWebサイトから価格情報を取得する場合、Manusはまず、ユーザーの指示を理解します(「A社、B社、C社のWebサイトから、商品Xの価格を抽出してください」)。次に、Manusは自動的にWebスクレイピングコード(BeautifulSoupやSeleniumを使用)を生成し、サンドボックス内で実行します。Webサイトの構造が複雑な場合や、JavaScriptで動的にコンテンツを読み込む場合でも、Manusはそれに対応するコードを生成し、必要に応じて修正を繰り返します。

また、APIを通じたデータ抽出も自動化されます。例えば、Google Analytics APIから自社のアクセス数を取得する場合、Manusは認証処理、APIリクエスト、レスポンス解析を自動的に実装します。

ステップ2: データ変換(Transform)の自動化

抽出したデータは、多くの場合、そのままでは使用できません。形式がバラバラであったり、不正なデータが含まれていたり、計算が必要だったりします。Manusは、Pandasを使用したPythonコードを自動生成し、これらの変換タスクを実行します。

例えば、複数の競合企業から抽出した価格データが、異なる通貨(ドル、ユーロ、円)で表記されている場合、Manusは自動的に為替レートを取得し、すべてを統一通貨に変換します。また、データに欠損値(NaN)が含まれている場合、Manusはその欠損値を補完するか、該当行を削除するかを判断し、実行します。さらに、複数の企業の価格データを一つの表にまとめ、平均値、最高値、最低値を計算することも、Manusが自動的に実行します。

ステップ3: レポート作成と共有(Load)の自動化

変換済みのデータは、最終的に人間が理解できる形式でレポート化される必要があります。Manusは、Matplotlibを使用してグラフを生成し、Markdownフォーマットでレポートをまとめ、PDFやCSV形式で出力します。さらに、このレポートを自動的にメール配信することも可能です。

定期実行を実現する`schedule`ツール:週次レポートの完全自動化

データパイプラインの真価は、それが「定期的に」実行されることで発揮されます。毎週月曜日の朝9時に、自動的にデータを抽出し、変換し、レポートを作成し、メール配信する。このような定期実行を実現するのが、Manusの`schedule`ツールです。

従来、定期実行を実現するには、Linux/Unixの`cron`コマンドを使用するか、Windowsのタスクスケジューラを使用する必要がありました。これらのツールは、技術的な知識が必要であり、設定が複雑です。Manusの`schedule`ツールは、ユーザーが自然言語で「毎週月曜日の朝9時に実行」と指示するだけで、自動的にスケジューリングを設定します。

さらに、Manusのサンドボックス環境での実行により、ユーザーのローカルマシンやサーバーに依存することなく、安定的に定期実行が実現されます。ネットワーク接続の問題、マシンのシャットダウン、ソフトウェアのアップデートなど、環境依存のエラーを排除し、高い信頼性を実現するのです。

活用事例:競合分析レポートの完全自動化

具体的な活用事例として、競合分析レポートの自動化を紹介します。

ある電子商取引企業が、毎週、主要競合3社(A社、B社、C社)のWebサイトから特定商品の価格とプロモーション情報を抽出し、自社との比較分析レポートを作成し、経営層にメールで配信する必要があります。従来は、営業担当者が毎週手作業でこの作業を行い、1時間以上の時間を費やしていました。

Manusを使用する場合、以下のステップで完全自動化が実現されます。

まず、ユーザーがManusに指示を与えます。「毎週月曜日の朝9時に、A社、B社、C社のWebサイトから商品Xの価格とプロモーション情報を抽出し、自社の価格と比較分析し、グラフ付きのレポートをMarkdown形式で作成し、経営層にメール配信してください」

Manusは、この指示を受けて、以下を自動的に実行します。

ステップ1: Webスクレイピングコードの生成と実行 Manusは、A社、B社、C社のWebサイトの構造を分析し、価格情報を抽出するBeautifulSoupコードを生成します。各企業のWebサイトが異なる構造を持っている場合でも、Manusは各企業に対応したコードを生成します。実行後、エラーが発生した場合(例えば、Webサイトのレイアウトが変更された場合)、Manusはそのエラーメッセージを分析し、コードを修正して再実行します。

ステップ2: データの変換と分析 抽出したデータをPandasで加工します。複数企業の価格データを一つの表にまとめ、自社との価格差を計算し、プロモーション情報を整理します。

ステップ3: グラフの生成とレポート作成 Matplotlibを使用して、競合企業との価格比較グラフを生成し、Markdownフォーマットのレポートにまとめます。レポートには、グラフ、分析結果、推奨アクション(例:「A社より5%安い価格設定を推奨」)が含まれます。

ステップ4: 定期実行の設定 `schedule`ツールを使用して、毎週月曜日の朝9時にこの一連のタスクを自動実行するよう設定します。

結果として、営業担当者は毎週1時間の手作業から解放され、その時間をより戦略的な業務に充てることができます。また、レポートの品質が向上し、エラーが排除されます。

データパイプラインの活用例:さらなる可能性

競合分析レポート以外にも、Manusのデータパイプライン機能は、様々なビジネスシーンで活用できます。

顧客データの自動集計: 複数の営業管理ツール(Salesforce、HubSpotなど)から顧客データを抽出し、統一されたダッシュボードで可視化する。

ソーシャルメディア分析: Twitter、Instagram、FacebookなどのSNSから自社ブランドに関する投稿を自動抽出し、センチメント分析(ポジティブ/ネガティブの判定)を行い、週次レポートを作成する。

在庫管理の自動化: 複数の倉庫システムから在庫データを抽出し、在庫不足を自動検出し、発注を自動実行する。

これらのユースケースは、すべてManusのデータパイプライン機能で実現可能です。

結論:データ駆動型経営を加速させるManus

Manusが実現する「データパイプラインの完全自動化」は、企業のデータ駆動型経営を大きく加速させます。従来は、専門知識を持つデータエンジニアが数週間かけて構築していたデータパイプラインを、Manusを使えば数分で構築できます。

さらに、定期実行により、毎週、毎月、毎日と、自動的にレポートが生成・配信されます。経営層は常に最新のデータに基づいた意思決定ができるようになります。

手動作業から解放され、より戦略的な業務に集中できる。これが、AIエージェント時代のビジネスの姿です。あなたの企業のデータパイプラインを、Manusで自動化してみてください。

コメント